-

Simple and Best

Simple and Best

-

Simple and Best

Simple and Best

安邦智库主张中国不宜发展“大AI”,而应该重点发展“小AI”。那么这种分析和主张是否有道理呢?成本因素是其中一个无法回避的关键点。

2022年底ChatGPT横空出世,开启了全球范围内人工智能的“狂飙之路”。从美国到中国,类似ChatGPT的大语言模型如雨后春笋般层出不穷,成为各个科技公司“秀肌肉”吸引资本的法宝。公开信息显示,截至2024年3月底,中国大陆已备案上线近120款大模型。完成生成式人工智能服务备案的大模型包括百度文心一言、阿里巴巴通义千问、华为云盘古、腾讯混元助手、OPPO安第斯、VIVO蓝心等。如果包含未备案的大模型,2023年全国AI大模型总数已经达到了238个。

从研发的速度和数量来看,中国在AI大模型方面似乎并没有落后世界领先水平多少。在不少国产大模型的发布会上,“大佬们”都在强调其大模型性能的优越性,动辄“比肩”甚至“领先”ChatGPT。例如科大讯飞在去年6月份召开的星火认知大模型V1.5升级版发布会上,就曾多次提及“讯飞星火离ChatGPT仅仅一步之遥”“今年十月份之前就会超过ChatGPT”等言论。

实际上所谓的“遥遥领先”言论,建立了一个很不好的“示范”,形成了一个坏榜样,后来者要不是也“遥遥领先”,似乎都不好意思再讲出口了。要评判大模型的性能,关键在于下限而非上限。通过小规模优质的数据集反复训练,模型展现良好的推理和判断能力并不难,这也是许多市面上的大模型拿出来展示的部分。但是,一旦来到市场上面对广泛的用户,这样的模型就“歇菜了”。此前在中国数字经济发展和治理学术年会上,清华大学苏世民书院院长薛澜就毫不避讳地指出,国产大模型很多是在国外开源大模型的基础上“套壳”或“组装”而来的。从模型的性能下限来看,国产大模型在逻辑判断和推理能力上与国外大模型相比还有很大的“提升”空间。

众所周知,大模型的三要素是算法、算力和数据。在开源大模型的加持下,算法结构对国产大模型的制约比较有限。就如当年安卓系统开源彻底改变智能手机系统的格局一般,开发者反而可以将焦点转移至大模型的其他要素和商业应用上。真正制约中国发展大模型的因素是算力和数据,这是中国在AI硬件上难以逾越的鸿沟,涉及巨大的、惊人的成本投资。对此,安邦智库(ANBOUND)首席研究员陈功先生曾指出,在通用大模型,也就是“大AI”方面,受制于客观条件,中国并不宜与美国的方向“死磕”,发展上宜巧不宜拙,不宜使蛮力。因此,他认为中国适宜发展其实是“小AI”,这种面向产业、产品,有强烈应用背景的人工智能模型才是中国人工智能未来的发展方向。

目前国内AI市场还是一派“乱斗”的局面。在OpenAI等国外大模型成本普降和产品迭代更新迅速的压力下,国产大模型还来不及打磨质量就开启了一轮声势浩大的“降价潮”。字节跳动、阿里云、百度、科大讯飞、腾讯等科技巨头近期纷纷宣布将大模型价格降到最低,甚至免费。这场景仿佛似曾相识,勾起了人们对“千团大战”“O2O混战”“网约车补贴大战”等移动互联网时代的记忆。不过,作为重资产、重资本的产业,大模型这场价格战不是一般企业打得起的。大模型时代,模型训练和推理成本构成了每个大模型创业公司必须面临的增长陷阱。

大模型是典型的“大力出奇迹”的产品,纵览全球最先进的大模型,背后都有强大“钞能力”的金主支持。美股“七巨头”自不必说,投资人的资金被源源不断地“烧”给大模型。例如微软在4月份表示,最近一个季度的资本支出为140亿美元,比去年同期增长了79%,由于AI基础设施投资,这些成本“大幅增加”。谷歌母公司Alphabet也表示,上一季度支出为120亿美元,比去年同期增长91%,并预计今年下半年的支出将“达到或超过”这一水平。与此同时,Meta也上调了对今年投资的预期,目前认为资本支出将达到350亿至400亿美元,在这一区间的上限将增长42%。值得注意的是,这些“大AI”项目都是动辄数千亿人民币的投入,甚至还远超半导体芯片潮的投资。

更多的训练数据、更大的模型、更多的芯片、数据中心和能源算力,这些都是科技公司的“不可承受之重”,必将拖垮大多数的国产大模型。“大AI”的开发和维护成本具体可以分解为以下几个方面:

首先是AI模型的数据成本。随着模型越来越复杂,大模型对训练数据的要求也在不断提高。据报道,前期生成式AI模型主要通过从公共网页中获取的图像、文本、音频、视频和其他数据(其中一些是有版权的)进行训练。但随着法律诉讼的增多,AI公司开始选择付费。线上社区Reddit称他们已通过向谷歌和OpenAI等提供组织许可数据赚取了数亿美元。AI训练数据市场预计将在十年内从现在的约25亿美元增长到接近300亿美元。“巧妇难为无米之炊”,字节跳动此前就被爆出通过ChatGPT生成的数据训练自家的大语言模型,最终被ChatGPT封禁调用接口。此外,数据清洗和标注也是确保数据质量的重要环节,需要大量的人工和自动化工具来处理不一致、重复、包含噪音的数据,增加了大模型的数据成本。

其次是AI模型的训练成本。OpenAI首席执行官奥尔特曼(Sam Altman)表示,训练GPT-4的成本超过1亿美元。AI初创公司Anthropic首席执行官阿莫代(Dario Amodei)也称,目前市场上的人工智能模型的训练成本约为1亿美元。阿莫代表示,现在正在训练的模型,以及将在今年晚些时候或明年年初推出的模型,成本接近10亿美元。在2025年和2026年,其公司训练模型的成本将接近50亿美元或100亿美元。

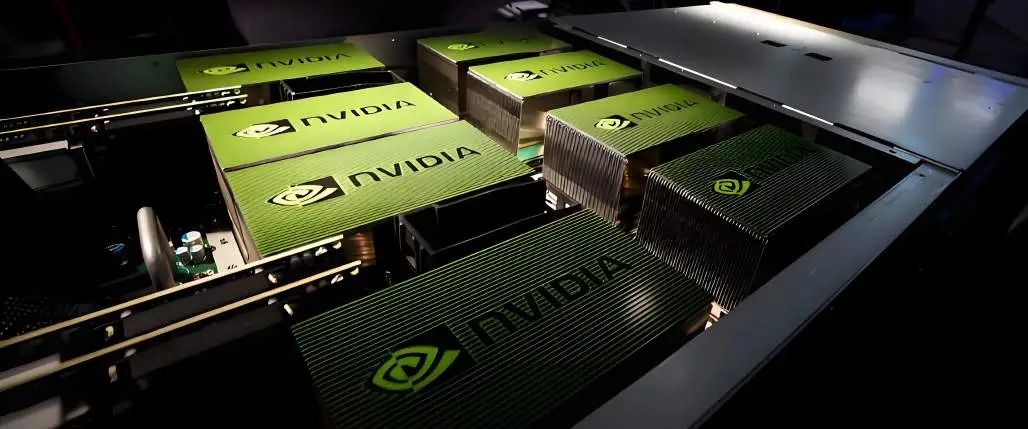

还有开发AI的芯片支出。就算有源源不断地供应,由于芯片决定了模型的算力,这项开支也巨大。据报道,英伟达的H100图形芯片售价约为3万美元。元公司首席执行官扎克伯格(Mark Zuckerberg)此前曾表示,公司计划在今年年底前购买35万块H100芯片,以支持其人工智能研究工作。以此计算,这又是上千亿人民币的投资。

最后是云服务中心的成本。每一座数据中心的成本都以亿来计算。例如,微软公司与阿联酋AI公司G42宣布,双方将合作投资10亿美元在肯尼亚建设一个数据中心,投资40亿欧元在法国建设AI数据中心和云基础设施。过去两年里,亚马逊也已承诺斥资1480亿美元在全球建设和运营数据中心,以应对AI应用和其他数字服务需求的激增。为保证这些数据中心的顺利运营,微软和亚马逊都花费了数十亿美元甚至百亿美元投资再生能源电力。

鉴于大模型的开发和维护费用高昂,资产不雄厚的AI公司很可能撑不过“凌冽寒冬”。尤其对中国来说,没有政府的政策支持,没有华尔街资金的追捧,科技公司的财力将很难支持它们熬过行业的恶性竞争。据全球经济分析公司BCA Research美国股票首席策略师唐克尔表示,尽管科技公司已经在AI领域开展了大量工作,但直到现在为止这些科技公司仍处在为AI大把花钱的阶段,而不是靠AI挣钱的阶段。财报数据显示,AI龙头之一的科大讯飞一季度亏损超3亿元,较去年同期亏损5789.53万元再度放大。

因此,从成本-收益的角度出发,安邦的观点得到了进一步的验证,即国产大模型不应该再继续卷“大AI”,中国大部分的AI大模型是经不起这样“卷”的。未来中国的AI产业,必然是被极少数的AI大厂垄断大模型,对于行业里的其他企业,应该基于开源大模型开发针对具体应用场景的垂直领域的小模型,即“小AI”。

当前国内呈现AI大模型“乱斗”的局面,恶性竞争不断加剧。受制于数据和算力的限制,中国的“大AI”很难实现从0到1的创新突破,难以与国外大模型匹敌。因此安邦智库提出应该避开硬件缺陷,发挥优势聚焦“小AI”。从AI大模型的成本考量,这一点也能得到佐证。“大AI”高昂的开发和维护成本——包括数据成本、训练成本、芯片支出以及云服务中心的费用对科技企业继续卷“大AI”构成了挑战,大部分的大模型会在“烧钱”的同时“燃尽”自己的生命。因此,中国AI产业更适宜发展针对特定应用场景的小模型,即“小AI”,以提高成本效益,并避免陷入无谓的竞争与资本浪费。

本文部分图片来自网络,侵权删

核心观点来自于:安邦智库创始人、首席研究员 陈功;安邦智库研究员 陈莉对本文做出了重要的贡献,并是本文署名作者。

如需文章转载或者预约采访,请联系我们

010-56763013

安邦智库(ANBOUND)创建于1993年,是源自中国本土的跨国智库机构,30年来坚持基于信息分析的战略问题研究和政策分析,在宏观经济金融、产业和城市等领域享有知名度,为全球超过8000多家客户提供战略咨询服务。